Psychopathische AI

Wenn Computer Texte schreiben

Vor einiger Zeit hat mich die Frage beschäftigt, ob Computer eigentlich fähig sind, eigenständig und auf automatisierte Weise Texte zu produzieren. Die Antwort lautete: Ja, sind sie. Und zwar dann, wenn man von algorithmusbasiertem Texten spricht, bei dem aus Kenndaten einer Datenbank Sätze nach bestimmten Regeln geformt werden, die dann als Texte für den menschlichen Leser verständlich und nachvollziehbar sind. Texte, die auf diese Weise entstehen, werden in folgenden Bereichen genutzt.

- Finanzanalysen

- Sportberichterstattung

- Wetterberichten

- Umweltberichterstattung (etwa aus Sensordaten zu Erdbeben)

- Horoskopen

Godfather of Deep Learning

Wenn aber von Maschinen-Intelligenz (AI) die Rede ist, ist letztlich auch gemeint, dass Computer lernfähig sind. Und damit betreten wir das Feld des britischen Informatikers und Kognitionspsychologen Geoffrey Hinton, der sich mit Sprach- und Bilderkennung befasste und im Jahr 1986 den wissenschaftlichen Durchbruch mit seinen Arbeiten zu neuronalen Netzwerken erlebte, wonach Computer ähnlich agieren, wie das menschliche Gehirn. „Deep Learning“ nennt sich das. Die Praxis war damals zwar noch nicht reif dafür (so fehlte etwa die Rechenleistung, die dafür benötigt wurde) doch heute ist es möglich.

Also was heißt Deep Learning? Stellen wir uns einmal vor, wie wir als Kinder die Welt erfahren haben. Wie lernt ein Kleinkind was Schokoladen-Eis ist? Es ist ein heißer Sommertag und das Kind ist mit seinen Eltern unterwegs und plötzlich halten alle vor einem bunten Eissalon und das Kind streckt seine Hand aus und bekommt eine Tüte hingestreckt, es greift danach und macht es wie die anderen und kostet davon und weiß dann was Schokoladen-Eis ist.

Soll im Vergleich dazu ein Computer lernen, was Schokoladen-Eis ist, dann benötigt das Computerprogramm Millionen von Bildern zu den Erregungszuständen: „Schokoladen-Eis“ und „Nicht Schokoladen-Eis“.

Denn: ein künstliches System lernt aus Beispielen und kann nach Beendigung der Lernphase verallgemeinern. Es erkennt Muster und Gesetzmäßigkeiten in den Lerndaten. Aus den bereits vorliegenden Ergebnissen werden sohin Erkenntnisse aus der Daten-Charakteristik abgeleitet, die sich aus den berechneten Wahrscheinlichkeiten ergeben. Für Computer ist es also wichtig, möglichst viele Daten zu bekommen, um aus den Erfahrungen zu lernen und dann verallgemeinern zu können.

Kehren wir also zur anfänglichen Frage der Maschinen-Ethik zurück.

Die psychopathische AI

Neulich ging eine Meldung durch die Netze, wonach Forscher die erste psychopathische AI der Welt erschaffen hätten.

Der Hintergrund war ein Deep Learning Projekt. Den Wissenschaftlern des MIT (Pinar Yanardag, Manuel Cebrian, Iyad Rahwan) ging es darum, einen Algorithmus auf Basis von Deep Learning zu schulen und dabei zu zeigen, wie wichtig es ist, dem eingespeisten Datenmaterial Beachtung zu schenken.

Tut man das nämlich nicht, so kann es zu einem Bias – also zu einer Verzerrung – kommen. Ein solcher Bias, kann auch durch die bewusste Selektion der Datenquellen entstehen.

Genau das zu demonstrieren, darum ging es dem Forscher-Team am MIT. Dem neuronalen Netzwerk mit dem Namen Norman wurden also ausschließlich grausame Bilder von Todesfällen und Gewalt aus dem Social-News-Aggregator Reddit präsentiert, also ganz bewusst nur ein bestimmter Teil der Welt. Norman wurde übrigens, wie man sich leicht denken kann, nach dem Hauptdarsteller aus dem Alfred Hitchcock-Film „Psycho“ benannt.

Parallel dazu haben sie ein weiteres neuronales Netz mit Standardbildern aus MS COCO trainiert, das insbesondere Aufnahmen von Tieren und Alltagsgegenständen enthält.

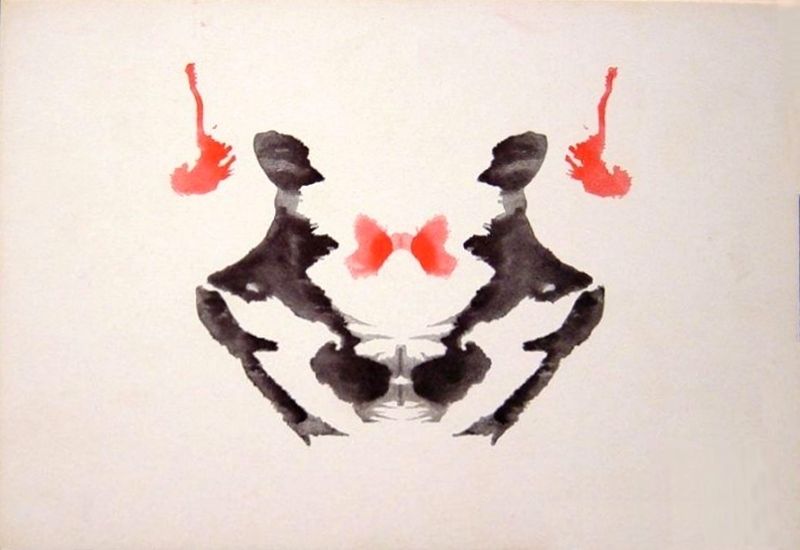

Dann ging es zum Test. Die Forscher wählten dafür den Rohrschachtest, ein psychodiagnostisches Testverfahren, bei dem es darum geht, aus tintenklecksartigen Bildern Interpretationen zu liefern.

Und tatsächlich: Norman interpretierte die Tintenflecken erkennbar düsterer als seine Vergleichs-KI. Normen sah nicht, wie die andere KI Blumenvasen, Vögel und Schirme, sondern Personen, die erschossen wurden, sich umbrachten oder in eine Knetmaschine gezogen wurden.

Das Fazit der Forscher: Hier finde sich ein zentraler Aspekt in der Debatte um AI und Moral. Denn auf Basis des Datenmaterials sei es möglich, dass eine KI menschliche Vorurteile übernimmt, selbst wenn die dahinterliegende Architektur des Algorithmus fehlerlos sei.

Google befasst sich übrigens mit genau diesen Fragen sowie der zunehmenden Forderung nach Ethik und Moral in selbstlernenden Computer-Systemen.

Sundar Pichai, CEO hat dazu folgende Prinzipien veröffentlicht.

Die Grundsätze lauten verkürzt:

- Sei sozial: Berücksichtige eine breite Palette von sozialen und wirtschaftlichen Faktoren und agiere dort, wo du meinst, das der wahrscheinliche Gesamtnutzen die vorhersehbaren Risiken und Nachteile erheblich übersteigt. Respektiere die kulturellen, sozialen und rechtlichen Normen der Länder, in denen wir tätig sind.

- Vermeide unfaire Verzerrungen (insbesondere im Bereich Rasse, Ethnizität, Geschlecht, Nationalität, Einkommen, sexuelle Orientierung, Fähigkeiten und politische und religiöse Überzeugung).

- Achte auf Sicherheit: Wende strenge Sicherheitsvorkehrungen an, um unbeabsichtigte Ergebnisse zu vermeiden, die zu einer Gefährdung führen können

- Sei Menschen gegenüber verantwortungsvoll, biete also genügend Möglichkeiten für Feedback.

- Achte auf Datenschutz-Grundsätze: Transparenz und Kontrolle der Daten

- Halte hohe wissenschaftliche Exzellenz: Beteilige dich an Best Practice und Forschung, die es mehr Menschen ermöglicht, nützliche KI-Applikationen zu entwickeln.

Insbesondere wird Google keine KI in den folgenden Bereichen verfolgen oder einsetzen:

- Technologien, die einen Gesamtschaden verursachen oder verursachen können. (Vorbehaltlich einer Risiko-Nutzen-Analyse.)

- Waffen oder andere Technologien, deren Hauptzweck oder Anwendung darin besteht, Personenschäden zu verursachen oder direkt zu erleichtern.

- Technologien, die Informationen sammeln oder zur Überwachung verwenden, die gegen international anerkannte Normen verstoßen.

- Technologien, deren Zweck gegen die allgemein anerkannten Grundsätze des Völkerrechts und der Menschenrechte verstößt.

Erinnert an die Versuche früher Roboter-Gesetze … https://www.ubifacts.org/robotergesetze/

@UBIFACTS/2018